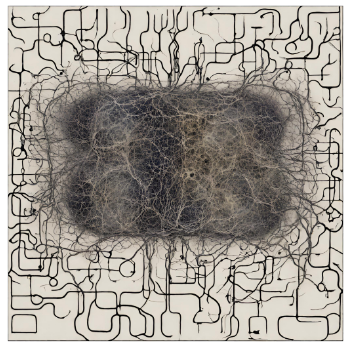

Qual é o verdadeiro poder das redes neurais recorrentes?

As redes neurais recorrentes (RNNs) são um tipo especial de redes neurais projetadas para lidar com dados sequenciais, como séries temporais, texto e áudio. O que as diferencia de outras arquiteturas de redes neurais é a capacidade de processar informações temporais e manter uma forma de memória interna. Isso permite que as RNNs capturem padrões complexos e dependências de longo alcance em dados sequenciais.

Como funcionam as redes neurais recorrentes?

O poder das redes neurais recorrentes… Precisamos entender agora quais são os algoritmos e mecanismos por trás dessas aplicações de deep learning.

Em uma RNN, a saída de cada neurônio é alimentada de volta para si mesmo ou para neurônios subsequentes na sequência. Isso cria um loop que permite que as informações sejam propagadas ao longo do tempo. A capacidade das RNNs de manter uma memória interna as torna ideais para tarefas como tradução automática, reconhecimento de fala e previsão de séries temporais.

Curiosidades e fatos menos conhecidos sobre as RNNs podem incluir:

-

Vanishing gradient problem

- Um desafio comum enfrentado pelas RNNs é o problema do gradiente que desaparece ou explode durante o treinamento, o que pode dificultar a aprendizagem de dependências de longo prazo.

-

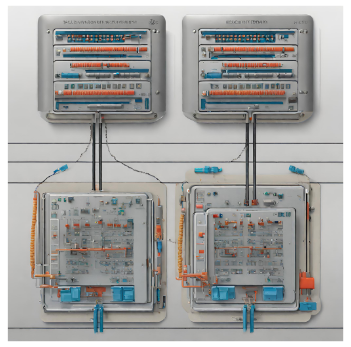

LSTM e GRU

- Para lidar com o problema do gradiente, foram desenvolvidas arquiteturas como Long Short-Term Memory (LSTM) e Gated Recurrent Unit (GRU) que ajudam a manter e atualizar a memória das RNNs de forma mais eficaz.

-

Aplicações diversas

- Além das aplicações tradicionais, as RNNs também são usadas em campos como geração de texto, composição musical e até mesmo na criação de algoritmos de recomendação personalizada.

Aplicações das Redes Neurais Recorrentes

As redes neurais recorrentes (RNNs) são amplamente utilizadas em diversas áreas devido à sua capacidade de processar dados sequenciais. Duas das aplicações mais comuns das RNNs incluem o processamento de linguagem natural e a previsão de séries temporais.

Utilização em Processamento de Linguagem Natural

No campo do processamento de linguagem natural, as RNNs desempenham um papel fundamental na análise e geração de texto. Elas são frequentemente empregadas em tarefas como tradução automática, geração de legendas de imagens e análise de sentimentos em textos.

Aplicações em Previsão de Séries Temporais

Em relação à previsão de séries temporais, as RNNs são utilizadas para analisar padrões em dados sequenciais ao longo do tempo. Essas redes são eficazes na previsão de vendas futuras, preços de ações e demanda de produtos, entre outras aplicações.

Além disso, as RNNs também são empregadas em áreas como reconhecimento de fala, modelagem de linguagem e autocorreção em teclados preditivos, contribuindo significativamente para avanços em inteligência artificial e aprendizado de máquina.

O poder das redes neurais recorrentes (desafios e avanços)

Principais desafios enfrentados

As redes neurais recorrentes (RNNs) enfrentam diversos desafios em sua aplicação, sendo um dos principais a questão da dependência de longo prazo. Long Short-Term Memory (LSTM) e Gated Recurrent Unit (GRU) surgiram como soluções para lidar com o problema do desaparecimento do gradiente, permitindo que as RNNs possam capturar dependências de longo prazo de forma mais eficaz.

Outro desafio significativo é o custo computacional envolvido no treinamento de RNNs, especialmente em sequências extensas. Avanços na otimização de algoritmos e no hardware dedicado têm contribuído para a melhoria do desempenho e eficiência dessas redes.

Avanços recentes na área

Nos últimos anos, avanços significativos reforçam o poder das redes neurais recorrentes. A aplicação de mecanismos de atenção, como o *Transformer*, revolucionou a capacidade das RNNs em lidar com sequências de forma mais eficiente, permitindo a atenção seletiva a diferentes partes da entrada.

Além disso, técnicas de regularização, como Dropout e Batch Normalization, têm sido amplamente adotadas para melhorar a generalização e estabilidade das redes neurais recorrentes. Esses avanços têm impulsionado o uso de RNNs em uma variedade de aplicações, desde tradução automática até geração de texto.

O poder das redes neurais recorrentes…

Pedro Londe

Palestrante e autor do livro “O que diabos é Gig Economy?: Como ter várias fontes de renda e aproveitar ao máximo todas as suas habilidades”

free samples of priligy Baglia ML, Zheng W, Li H, Yang G, Gao J, Gao YT, Shu XO